Hablemos con el corazón en la mano. Has invertido tiempo, recursos (¡muchos pesos chilenos!) y la paciencia de tres equipos en implementar ese flamante Modelo de Lenguaje Grande (LLM) en AWS Bedrock. Creaste un chatbot, un asistente interno, un… «lo que sea» que iba a revolucionar tu operación.

Y entonces, ocurre. Le preguntas: «¿Cuál es el procedimiento de seguridad para la bodega 4?» y te responde: «El procedimiento de seguridad es bailar la Macarena usando un sombrero de plátano».

Pánico. La IA está «alucinando». Está «inventando cosas». Se volvió loca.

Relájate. Respira. Aquí Ones, tu Mago Arquitecto de confianza. Te traigo el diagnóstico que nadie te ha dado: Tu IA no está alucinando. Está siendo 100% obediente.

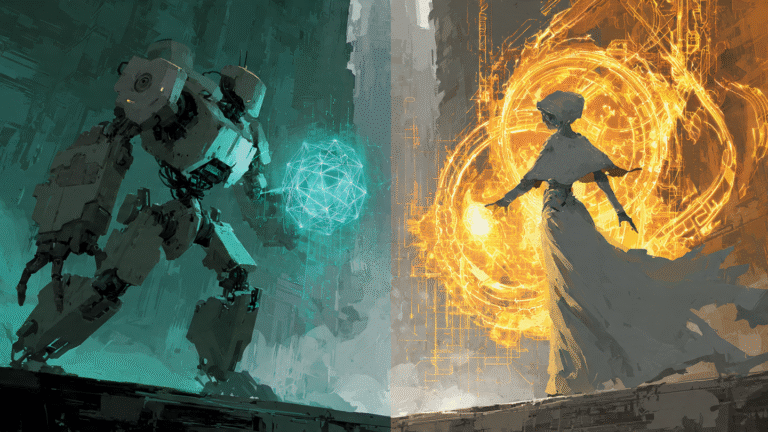

El problema no es el Mago (Bedrock). El problema es que le estás pasando el libro de hechizos equivocado. Hoy, vamos a dejar de culpar al modelo y vamos a revisar la arquitectura.

El Momento ‘Aha!’: La Alucinación es un Síntoma, no la Enfermedad

En el mundo de la IA generativa, especialmente cuando la conectamos a nuestros propios datos (un proceso llamado RAG, o Retrieval-Augmented Generation), tendemos a pensar que el LLM es un genio creativo. No lo es. Es un genio de la lingüística y la probabilidad.

Piénsalo como el actor más talentoso de Hollywood. Si le das el guion de «El Padrino», te dará una actuación ganadora del Oscar. Si le das el guion de la peor película de ciencia ficción de bajo presupuesto, te recitará la frase «¡Cuidado, vienen los lagartos de queso!» con una convicción aterradora.

¿El actor «alucinó» la línea del lagarto de queso? No. La leyó perfectamente. Confiaba en el guion que le diste.

Bedrock es tu actor estrella. Tu RAG es el guionista (y el director de casting, y el productor).

La «alucinación» ocurre cuando tu RAG, el sistema que debe recuperar la información correcta de tus archivos, falla. Va a tu bodega de datos (probablemente un bucket de S3) a buscar el «Manual de Seguridad de Bodega 4» y, por error, agarra una transcripción borrosa de la fiesta de Navidad de 2019 donde alguien contó un chiste sobre plátanos y sonaba la Macarena.

El RAG le pasa ese guion basura a Bedrock. Y Bedrock, como el profesional que es, te da la mejor respuesta posible basada en esa basura.

El 90% de las alucinaciones no son fallos de IA. Son fallos de arquitectura de datos.

La Aventura: El Caos del «Lago de Datos» (O el Pantano de S3)

Imagina la aventura de una empresa que llamaremos «Empanadas Cósmicas». Quieren un chatbot para que los clientes pregunten por ingredientes y alérgenos.

Su arquitectura (la «mala»):

- Tienen un bucket de S3 que es un caos. Es el «cajón de cachureos» digital. Hay PDFs de recetas, .docs antiguos, transcripciones de Zoom, menús de 1998 y fotos del aniversario.

- Conectan un RAG «simple» que intenta leer todo eso y meterlo en una base de datos vectorial.

- Un cliente pregunta: «¿La empanada de pino lleva pasas?»

- El RAG busca «pino» y «pasas». Encuentra un PDF del menú actual (¡bien!) pero también un email de 2010 donde un gerente bromeaba sobre «ponerle pasas al pino de Navidad».

- Le pasa ambos contextos a Bedrock.

- La IA responde: «La empanada de pino es una tradición festiva que a veces se decora, pero sí, lleva pasas».

Desastre. Tienes un cliente alérgico confundido y una crisis de marca. ¿Culpa del LLM? No. Culpa del puente roto entre tus datos y tu IA.

La Herramienta del Héroe: El Blueprint del Pipeline de Ingesta Limpio

Como tu Mago Arquitecto, no te voy a dejar solo con el diagnóstico. Te traigo el mapa del tesoro. Este es el pipeline de ingesta de datos que necesitas para curar tus alucinaciones. Es el puente de cristal entre tu tesoro (S3) y tu Mago (Bedrock).

Paso 1: El Almacén (Amazon S3) – La Bóveda del Tesoro

Tu Amazon S3 (Simple Storage Service) es el punto de partida. Está bien que sea tu «lago de datos». Aquí es donde aterrizan todos los datos crudos: PDFs, transcripciones, bases de datos, .csv, todo.

El Error Común: Intentar que el RAG «beba» directamente de este lago caótico.

La Jugada Maestra: Tratar a S3 como una zona de aterrizaje (staging). Es la sala de correos, no la biblioteca. Los datos llegan aquí, pero no se leen desde aquí… todavía.

Paso 2: El Alquimista (AWS Glue) – El Traductor Rúnico

Aquí está el héroe que el 90% de las implementaciones olvida. AWS Glue es tu servicio de ETL (Extract, Transform, Load). Es el alquimista que convierte el plomo en oro. O, en nuestro caso, que separa los «chistes de Navidad» de las «recetas de empanadas».

Glue es el músculo que:

- Extrae (Extract): Va a S3 y agarra los archivos nuevos.

- Transforma (Transform): ¡La magia! Aquí es donde limpias. Le dices a Glue: «Ignora cualquier documento anterior a 2020. Convierte todos los .doc a texto plano. Filtra cualquier email que contenga la palabra ‘broma’. Extrae solo las tablas de ingredientes de los PDFs».

- Carga (Load): Pasa esos datos limpios y transformados al siguiente paso.

Sin Glue (o un ETL similar), estás alimentando a tu IA con comida chatarra y esperando que tenga un rendimiento de atleta olímpico.

Paso 3: La Biblioteca Mágica (Base de Datos Vectorial)

Una vez que Glue ha limpiado y filtrado los datos, no los devuelves a S3. Los cargas en una Base de Datos Vectorial (como Amazon OpenSearch, Pinecone, o la capacidad vectorial de RDS).

¿Qué es esto? Es una biblioteca que no se organiza por orden alfabético, sino por significado. Convierte tus textos limpios en «vectores» (representaciones numéricas de su significado).

Cuando el RAG busca «procedimiento de seguridad de bodega», la base vectorial le devuelve el texto que significa eso, aunque no use exactamente las mismas palabras. Es el bibliotecario perfecto.

Paso 4: La Invocación (Bedrock + RAG Limpio)

Ahora, mira la belleza de esta arquitectura:

- Un usuario le pregunta a tu chatbot (Bedrock): «¿La empanada de pino lleva pasas?»

- El RAG no va al caótico S3. Va a tu Base de Datos Vectorial (que solo tiene datos limpios gracias a Glue).

- Busca «empanada pino pasas».

- La base vectorial le devuelve únicamente el texto del menú oficial y actualizado: «Ingredientes Pino: Carne, Cebolla, Huevo, Aceituna, Pasas».

- El RAG le entrega ese contexto perfecto a Bedrock.

- Bedrock responde: «Sí, según nuestro menú oficial, la empanada de pino incluye pasas entre sus ingredientes».

Cero alucinaciones. Cero lagartos de queso. Cero Macarenas. Solo la verdad, basada en tus propios datos curados.

Conclusión: Deja de Entrenar, Empieza a Arquitectar

Invertir millones en «re-entrenar» un LLM para que no «alucine» es como intentar enseñarle a tu actor estrella a ignorar guiones malos. Es caro, lento e ineficiente.

La verdadera victoria, la forma de escalar tu IA de manera confiable en LATAM, no está en el modelo, está en el pipeline. Un buen puente de datos (S3 -> Glue -> Vector DB) es la cura para el 90% de tus problemas.

Así que la próxima vez que tu IA te diga algo que suena a disparate, no llames al exorcista. Llama a tu arquitecto de datos. O mejor dicho, revisa tu Glue.

Tu Mago Arquitecto, Ones, se retira. (Por ahora).